-

最强 3B「小钢炮」,代码数据全公开!推理随意开关,128k 超长上下文

文章详细介绍了 Hugging Face 最新发布的 SmolLM3 大型语言模型,该模型以 30 亿参数在小模型中脱颖而出,支持 128k 超长上下文和独特的双推理模式(think/no_think),并实现了全链路(训练、对齐、架构、数据)100%开源。文章深入阐述了 SmolLM3 在 Llama 架构基础上的多项关键优化,如 GQA 机制、NoPE 编码、文档内注意力屏蔽和稳定性优化。此外…- 0

- 0

-

Day 1/5:MiniMax-M1,全球首个开源大规模混合架构的推理模型

文章介绍了稀宇科技开源的新模型 MiniMax-M1,声称是全球首个大规模混合架构推理模型。M1 的显著优势在于支持 100 万上下文输入和 8 万 Token 推理输出,在长上下文和深度推理场景中效率高,算力消耗远低于竞品。文章指出,这得益于其独创的闪电注意力机制混合架构以及更快的强化学习算法 CISPO,大幅降低了训练成本。M1 在软件工程、长上下文理解和代理工具使用等面向生产力的复杂场景中表…- 0

- 0

-

OpenAI 深夜发布 GPT-4.1 系列模型,支持百万 Token 上下文编程

OpenAI 于 4 月 15 日发布了全新的 GPT-4.1 系列模型,包括 GPT-4.1、GPT-4.1 mini 和 GPT-4.1 nano 三款。这些模型在编程能力、指令遵循、长上下文理解和视觉能力方面均优于 GPT-4o,并支持高达 100 万 Token 的上下文窗口。GPT-4.1 作为旗舰级模型,擅长处理复杂任务;GPT-4.1 mini 在多个基准测试中超越 GPT-4o,降…- 0

- 0

-

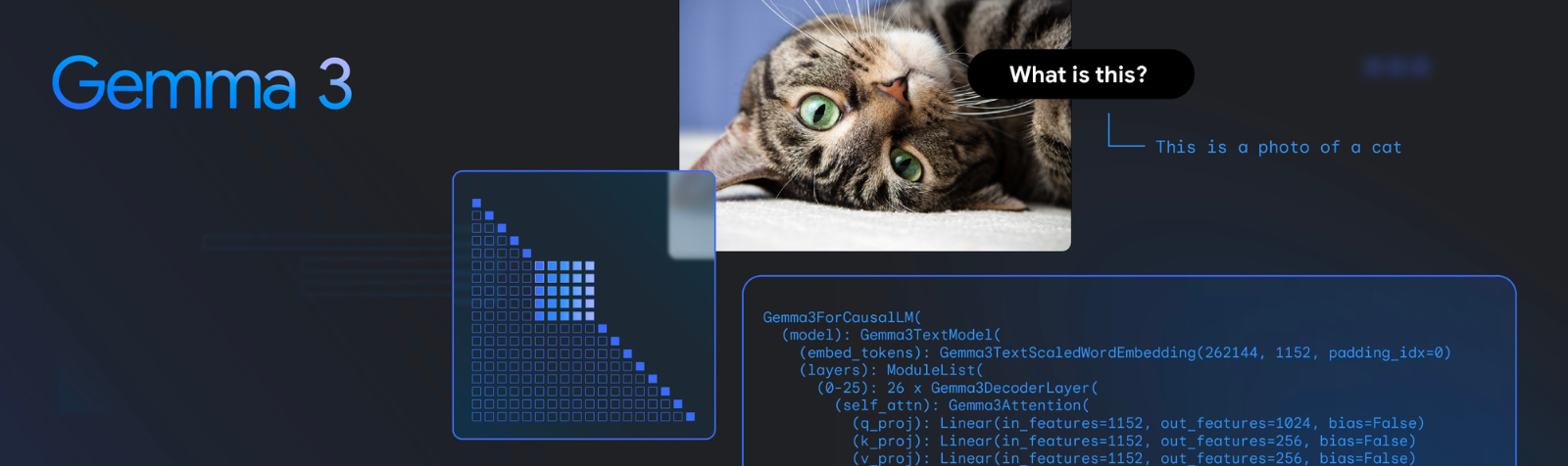

Gemma 3:新特性解析

这篇来自谷歌开发者博客的文章详细介绍了 Gemma 3 的新特性和架构改进。关键增强在于引入视觉语言能力,模型可通过自定义的 SigLIP 视觉编码器解读视觉信息。架构经过修改,通过采用 5 比 1 的交错注意力机制,降低了 KV 缓存的内存占用。KV 缓存内存通常会随着上下文长度的增加而增长。Gemma 3 支持更长的上下文长度,大型模型可处理高达 128k 个 tokens。此外,Gemma …- 0

- 0

长上下文

❯

个人中心

购物车

优惠劵

今日签到

有新私信

私信列表

搜索

扫码打开当前页

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

✈优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!