-

DeepSeek-R1 更新,思考更深,推理更强

DeepSeek 发布了其 R1 模型的小版本更新 DeepSeek-R1-0528,基于 DeepSeek V3 Base 基座,通过增强后训练显著提升了模型的思维深度和推理能力。新版本在数学、编程和通用逻辑等多项基准测试中表现优异,特别是在复杂推理任务如 AIME 2025 中准确率大幅提升。文章提到模型在解题过程中使用了更多 tokens 进行深入思考。此外,新版模型优化了幻觉问题,降低幻觉…- 0

- 0

-

DeepSeek V3.2 正式版:强化 Agent 能力,融入思考推理

DeepSeek 正式发布了两款具有里程碑意义的大语言模型:DeepSeek-V3.2 和 DeepSeek-V3.2-Speciale。DeepSeek-V3.2 旨在平衡卓越推理能力与高效输出长度,特别适用于日常问答和通用 Agent 任务,在公开推理 Benchmark 中已达到 GPT-5 水平,且相比同类模型显著降低了计算开销和用户等待时间。DeepSeek-V3.2-Speciale …- 0

- 0

-

从 o1-mini 到 DeepSeek-R1,万字长文带你读懂推理模型的历史与技术

文章详细梳理了推理模型从 OpenAI 的 o1-mini 到 DeepSeek-R1 的发展历程,并深入探讨了其背后的技术原理。首先介绍了推理模型与标准 LLM 的区别,强调了长思维链在推理过程中的重要作用。接着,文章深入分析了如何通过强化学习训练推理模型,特别是利用可验证奖励进行训练的方法。此外,还探讨了推理时间策略,如思维链和解码技术,以及并行解码和自我优化等方法。文章重点介绍了 DeepS…- 0

- 0

-

全新开源的 DeepSeek-OCR,可能是最近最惊喜的模型。

文章详细介绍了 DeepSeek 团队全新开源的 DeepSeek-OCR 模型,指出其并非传统意义上的 OCR 工具,而是一种革命性的长文本上下文处理方案。传统大模型在处理长文本时面临计算复杂度呈平方级增长的困境,DeepSeek-OCR 通过将文本内容“压缩”成二维图像,再编码为视觉 Token,大幅降低了上下文窗口的 Token 消耗,实现了高达 10 倍的压缩比并保持高识别准确率。文章通过…- 0

- 0

-

DeepSeek-R1 发布,性能对标 OpenAI o1 正式版

DeepSeek 正式发布了 DeepSeek-R1 模型,该模型在数学、代码、自然语言推理等任务上性能对标 OpenAI o1 正式版。DeepSeek-R1 在后训练阶段大规模使用了强化学习技术,极大提升了模型推理能力。DeepSeek 不仅开源了模型权重,还提供了 API 服务,允许用户通过设置 `model='deepseek-reasoner'` 调用思维链输出。此外…- 0

- 0

-

DeepSeek 新模型被硅谷夸疯了!用二维视觉压缩一维文字,单 GPU 能跑,"谷歌核心机密被开源"

文章详细介绍了 DeepSeek 最新开源的 DeepSeek-OCR 模型,该模型创新性地提出“上下文光学压缩”思路,利用视觉方式高效压缩文本信息,显著降低大模型处理长文本的计算开销。通过将文字信息转化为少量视觉 token,实现了高达 10 倍的压缩率,同时保持 97%的 OCR 解码准确率,并在主流文档解析基准 OmniDocBench 上取得了 SOTA 性能。其核心 DeepEncode…- 0

- 0

-

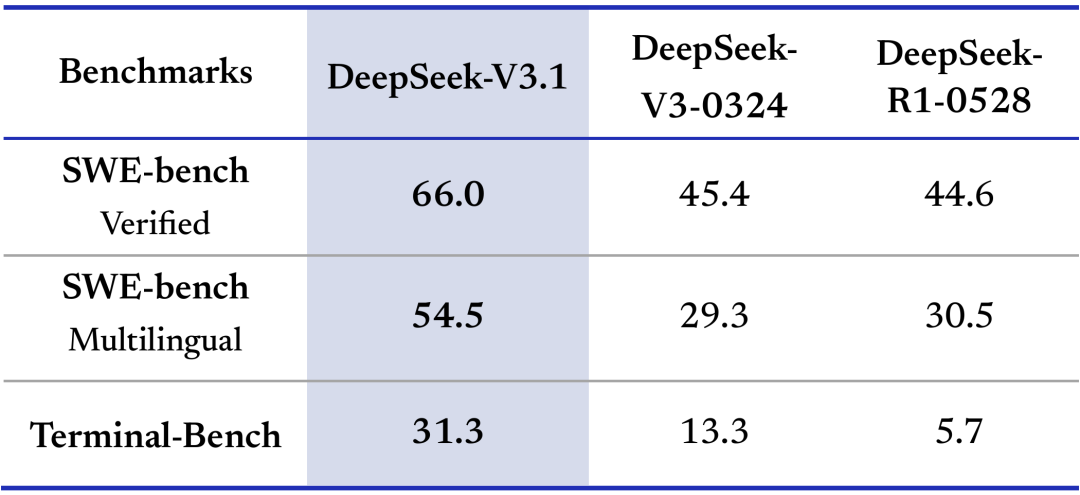

DeepSeek-V3.1 发布,迈向 Agent 时代的第一步

DeepSeek 正式发布 V3.1 模型,核心亮点包括创新的混合推理架构,使其能同时支持“思考模式”与“非思考模式”,并能自由切换。新模型通过 Post-Training 优化,大幅增强了在编程智能体(SWE、Terminal-Bench)和搜索智能体(browsecomp、HLE)任务中的表现。在思考效率方面,V3.1-Think 模式在保持性能的同时,能将输出 token 数减少 20%-5…- 0

- 0

-

DeepSeek 与元宝 “互动”!AI 助手日渐融入我们的生活

在科技迅速发展的今天,AI 助手已逐渐成为人们日常生活中不可或缺的一部分。12 月 24 日,DeepSeek 官方在小红书上与元宝互动,点赞并回应了元宝发布的年度报告,这一罕见的公开互动引起了行业的广泛关注。根据《元宝 ×DeepSeek 年度报告》,自今年 2 月接入 DeepSeek 以来,元宝的用户规模稳步增长,并在 12 月 14 日达到了使用高峰,增长幅度超过 100 倍。这一成绩使元…- 0

- 0

-

DeepSeek 开源 Prover-V2 强推理模型,网友:奥数从没这么简单过 | 机器之心

DeepSeek 发布了开源的 DeepSeek-Prover-V2 模型,包括 7B 和 671B 两个版本,专注于形式化定理证明。该模型专为 Lean 4 数学 AI 编程语言设计,通过递归定理证明流程收集数据,并使用 DeepSeek-V3 进行子目标拆解和推理步骤的形式化表达。模型训练分为两个阶段:高效非思维链模式和高精度思维链模式,最终在神经定理证明任务中达到当前最先进的性能,并在 Mi…- 0

- 0

-

Sebastian Raschka:关于 DeepSeek R1 和推理模型,我有几点看法

本文由著名 AI 研究者 Sebastian Raschka 撰写,全面解析了构建和改进推理模型的四种主要方法,包括推理时间扩展、纯强化学习 (RL)、监督微调加强化学习 (SFT + RL) 以及纯监督微调 (SFT) 和蒸馏。文章以 DeepSeek R1 为例,详细分析了其训练流程、开源特性和效率优势,并对比了不同方法的优劣。此外,文章还讨论了在有限预算下开发推理模型的可能性,介绍了 Sky…- 0

- 0

-

DeepSeek 关键技术详解

本文详细介绍了 DeepSeek V3 和 R1 系列模型的技术创新点。DeepSeek V3 在 MoE 架构上进行了改进,提出了细粒度专家划分和共享专家分离策略,并针对负载不均衡问题引入可学习的偏置项。此外,V3 还采用了群体相对策略优化(GRPO)、多头隐式注意力(MLA)、多令牌预测(MTP)和混合精度框架等技术,以提升训练效率和模型效果。DeepSeek R1 系列模型则专注于深度推理能…- 0

- 0

-

一场关于 DeepSeek 的高质量闭门会:比技术更重要的是愿景

本文总结了一场由拾象组织的关于 DeepSeek 的闭门讨论会,与会者包括顶尖 AI 研究员、投资人和从业者。会议旨在探讨 DeepSeek-R1 以始料未及的速度引发全球 AI 社区狂热现象背后的技术细节、组织文化及其在 AI 领域产生的深远影响。讨论内容涵盖了 DeepSeek 的创始人梁文锋的技术洞察力、DeepSeek 的技术特点如高效的 reasoning 模型和数据蒸馏技术、算力情况、…- 0

- 0

-

DeepSeek-V3 深夜惊爆上新!代码数学飙升剑指 GPT-5,一台 Mac 可跑

文章报道了 DeepSeek V3 最新版本 DeepSeek-V3-0324 的发布及其性能提升。该模型在代码和数学推理能力上均有显著提升,甚至在代码方面可以与 Claude 3.7 相媲美。尤其在前端开发等特定任务中,DeepSeek V3 展现出超越其他模型的潜力。此外,DeepSeek V3 采用 MIT 开源协议,允许自由修改和商业应用。该模型可在消费级设备上运行,如苹果 M3 Ultr…- 0

- 0

-

Deepseek V3/R1 技术内核 及 RAG 技术前沿进展

本文详细分析了 DeepSeek V3 和 R1 的技术内核及其在 RAG 技术上的前沿进展。首先,文章介绍了 DeepSeek 团队的长期主义和开源理念,以及其在混合专家模型(MoE)架构(包括细粒度专家分割和共享专家隔离)、推理能力强化和软硬件协同设计方面所做的创新。其次,文章深入探讨了 DeepSeek R1 如何通过纯强化学习和“左脚踩右脚”的迭代优化方式,在推理能力上取得突破,并利用模型…- 0

- 0

-

一文读懂|DeepSeek 新模型大揭秘,为何它能震动全球 AI 圈

本文深入剖析了 DeepSeek 最新发布的开源模型 R1,揭示了其在技术上的重大突破。DeepSeek R1 最核心的创新在于采用纯强化学习方法训练模型,使其自发涌现出强大的推理能力,这与传统依赖监督微调和复杂奖励模型的训练方式截然不同。R1-Zero 模型仅使用简单的准确性和格式奖励,就展现出“顿悟”式学习能力和优秀的跨领域迁移学习能力,在数学和编程竞赛中表现卓越。尽管 R1-Zero 存在可…- 0

- 0

-

V3→R1→V3.2|一文看懂 DeepSeek 技术演进

本文系统性地追溯了 DeepSeek 大模型从 V3 到 V3.2 的演进历程,详细阐述了每个主要版本背后的技术创新与考量。首先,文章介绍了 V3 版本中 MoE(专家混合)架构和 MLA(多头潜在注意力)机制,分别解决了大模型效率与长序列显存占用的问题。接着,R1 版本引入的 RLVR(可验证奖励的强化学习)训练范式,通过程序自动验证答案,显著提升了模型在数学和代码等推理任务上的准确性和可靠性,…- 0

- 0

-

SemiAnalysis 万字解析 DeepSeek:训练成本、技术创新点、以及对封闭模型的影响

文章详细分析了 DeepSeek 的技术架构、商业模式和市场表现。首先探讨了 DeepSeek 的硬件投入,包括约 5 万块 Hopper GPU 和超过 5 亿美元的投资,并指出其通过多头潜在注意力(MLA)大幅降低推理成本的关键技术创新。接着分析了 DeepSeek 在人才招聘、模型训练成本、以及与 OpenAI 等竞争对手的性能对比中的表现。文章还讨论了算法改进如何推动 AI 行业的快速发展…- 0

- 0

-

万字长文详解 DeepSeek 核心技术

本文详细介绍了 DeepSeek 系列模型的技术创新,包括 DeepSeek MoE 架构的细粒度专家划分、共享专家分离,以及为解决负载不均衡问题而提出的负载均衡策略。深入解析了 GRPO 算法相对于 PPO 的改进,通过减少 Value 模型来降低计算资源消耗。阐述了 MLA 如何通过低秩分解减少 KV Cache,降低推理成本。介绍了 MTP 如何通过一次性预测多个 token 来提升训练效率…- 0

- 0

-

DeepSeek 最强专业拆解来了,清交复教授超硬核解读

本文通过五位高校教授的深入分析,全面探讨了 DeepSeek 的技术原理、优化方法及未来发展方向。DeepSeek 通过优化策略显著提升了算力能效,降低了成本,并在写作能力上取得了飞跃。文章详细介绍了 R1 和 V3 模型的技术路线、训练流程及其与 OpenAI o1 的对比。DeepSeek 的创新策略包括 MoE 架构、负载均衡、通信优化和内存优化,展示了中国团队在 AI 领域的独立思考和创新…- 0

- 0

-

DeepSeek R1 之后,重新理解推理模型

文章对 DeepSeek R1 推理模型进行了全面解读,明确了推理模型的定义,即擅长解决需要复杂、多步骤生成的问题。分析了推理模型的优缺点,强调其在复杂任务上的优势,以及在简单任务上的低效。详细介绍了 DeepSeek R1 的三个变体:R1-Zero (纯 RL 训练)、R1 (SFT+RL 训练) 和 R1-Distill (蒸馏模型),并对比了它们的技术特点和性能差异,强调了 R1 在纯 R…- 0

- 0

-

DeepSeek 上线两天后再回看:一次“小更新”,一场架构“豪赌”

文章深入分析了 DeepSeek V3.1 模型的最新更新。核心亮点并非简单的上下文扩展,而是其底层架构从分离式转向混合推理,旨在简化部署和提高算力利用效率。V3.1 在编程能力上取得显著进步,在 Aider 等基准测试中表现优异,并大幅增强了智能体(Agent)能力,尤其在软件工程和终端控制任务上实现跃迁。同时,通过思维链压缩训练,V3.1 显著降低了使用成本并提升了生成速度。然而,这种模型融合…- 0

- 0

-

刚刚,DeepSeek-R1 论文登上 Nature 封面,通讯作者梁文锋 | 机器之心

文章报道了 DeepSeek-R1 研究登上《Nature》封面,强调了其在利用强化学习提升大语言模型(LLM)推理能力方面的创新。DeepSeek-R1 模型通过群组相对策略优化(GRPO)和精巧的奖励设计,使模型能够自我验证和反思,逐步解决复杂问题,显著提高了在编程和科学问题上的表现。文章特别指出,DeepSeek-R1 是首个通过权威学术期刊同行评审的大语言模型,这一“程序价值”被视为 AI…- 0

- 0

-

DeepSeek-V3.2-Exp 发布,训练推理提效,API 同步降价

深度求索正式发布实验性模型 DeepSeek-V3.2-Exp,其核心创新是引入了 DeepSeek Sparse Attention(DSA)稀疏注意力机制。该机制在不显著影响模型输出效果的前提下,大幅提升了长文本场景下的训练和推理效率。文章指出,V3.2-Exp 在公开评测集上的表现与前一代 V3.1-Terminus 基本持平。为推动技术普惠和社区发展,DeepSeek 同步大幅下调 API…- 0

- 0

-

DeepSeek 的终极野心:把大语言模型的基本语言都改造成图像|DeepSeek 新论文解读

文章深入解读了 DeepSeek-OCR 项目,该项目旨在通过光学压缩技术解决大语言模型(LLM)长上下文处理的算力瓶颈。核心思想是将文本信息高效地渲染成图像,并由视觉语言模型(VLM)从图像中解压信息,从而用远少于文本 token 的视觉 token 表示相同内容。Andrej Karpathy 等专家认为,此举带来了信息压缩、更通用的信息流、更强的处理方式以及删除分词器的四大好处。文中详细介绍…- 0

- 0

DeepS

❯

个人中心

购物车

优惠劵

今日签到

有新私信

私信列表

搜索

扫码打开当前页

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

✈优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!